Aufdecken von internem Link-Potenzial mit der Screaming Frog SEO Spider

Interne Verlinkung spielt nach wie vor eine wichtige Rolle bei der Performance der eigenen Webseite. Als „Durchblutung“ der Seite schicken interne Links Nutzer und Linkpower quer über die Domain und priorisieren damit Unterseiten. Somit ist die interne Verlinkung nicht nur ein wichtiger Faktor für die Nutzerführung auf der Seite sondern hat auch Einfluss auf die organischen Rankings.

Damit bei der Verlinkung keine Potenziale links liegen gelassen werden oder „unwichtige“ Seiten zu stark verlinkt werden, möchte ich eine Möglichkeit schildern, mit deren Hilfe ihr einen guten Überblick über den Status der Link-Struktur erhaltet. Was man dazu braucht: Screaming Frog SEO Spider und Website-Daten (z.B. durch Google Analytics).

Ziele

- Unterseiten entdecken, welche bereits gute Traffic-Werte (nicht nur organisch) aufweisen und durch zusätzliche Verlinkung noch gepusht werden können.

- Verschwenderische Verlinkungen entdecken, die Linkpower an „unwichtige“ Seiten weitergeben.

Was wird benötigt?

- Liste aller URLs der Webseite (Bilder, CSS Dateien etc. können vernachlässigt werden)

- Analytics-Daten aller Unterseiten für einen möglichst großen Zeitraum

Vorgehen

Crawl-Setup

Zunächst soll die Seite gecrawlt werden. Dazu verwendet man am besten die Screaming Frog SEO Spider, welche in einer kostenlosen Version erhältlich ist. Diese Version kann allerdings nur 500 URLs crawlen. Eine Lizenz für die Vollversion kostet jährlich £99,00 und ist unter https://www.screamingfrog.co.uk/seo-spider/licence/ zu erwerben.

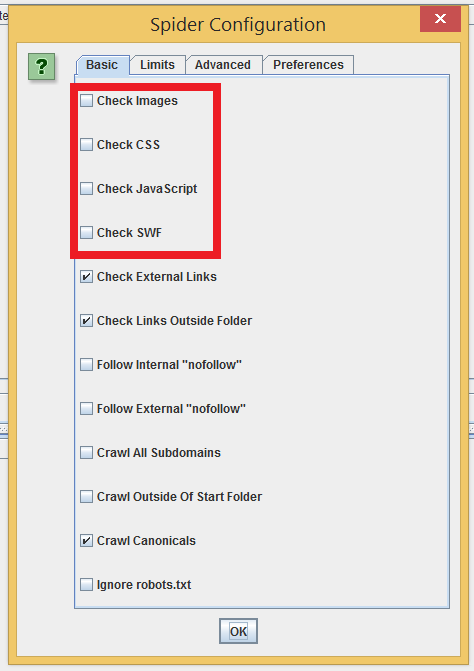

Um beim Crawl Zeit zu sparen wählt in der SEO Spider den Menüpunkt „Configuration“ > „Spider“. Dort wählt ihr alle unnötigen Typen wie Images, CSS, JavaScript und SWF ab. Alle anderen Einstellungen können beibehalten oder an Eure Bedürfnisse angepasst werden.

Dann könnt ihr den Crawl starten.

Achtung: Achtet darauf, dass ihr mit dem Crawl die Seite nicht lahmlegt. Gegebenenfalls sollte der Crawl mit der Technik abgesprochen werden. In den meisten Fällen sollte aber kein Risiko bestehen. Wer sich unsicher ist, kann die Belastung für die Webseite mindern, indem im Menü „Configuration“ > „Speed“ die Anzahl der maximal gecrawlten URLs pro Sekunde beschränkt oder reduziert wird.

Gegebenenfalls sind mehrere Anläufe zum Crawl nötig, bis ihr die passende Konfiguration gefunden habt. So kann man z.B. unter „Configuration“ > „Exclude“ unnötige Unterverzeichnisse ausschließen.

Nach Ende des Durchlaufs, ladet ihr Euch den Report als Excel Tabelle (oder CSV) herunter.

Analytics-Daten

Wie schon angesprochen, sollen weiterhin Daten aus der Tracking-Software in die Analyse einfließen. Im Beispiel sollen das Daten aus Google Analytics sein. Wählt für ein möglichst aussagekräftiges Ergebnis z.B. Daten des vergangenen Jahres.

Also im Google Analytics den Zeitraum auswählen, dann in der linken Sidebar „Verhalten“ > „Website-Content“ > „Alle Seiten“ auswählen, 5.000 Zeilen anzeigen lassen und diesen Report exportieren.

Daten matchen

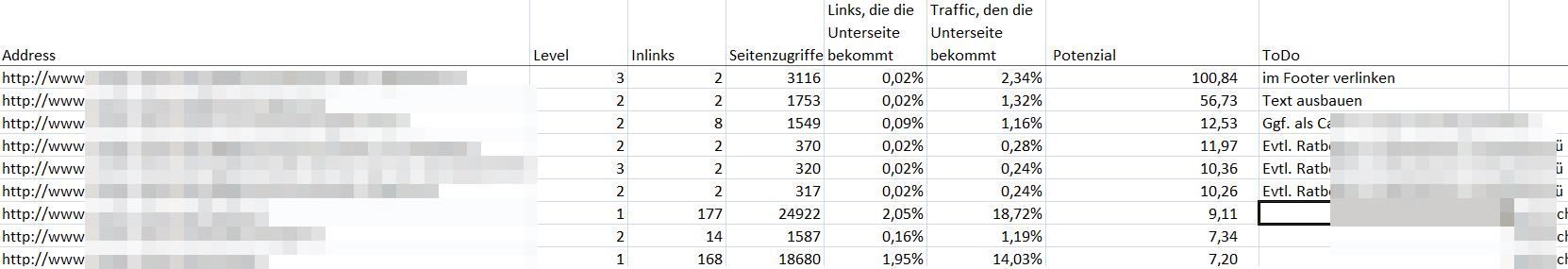

Nun sollen die beiden Reports gematcht werden. Ziel ist es, eine Tabelle mit den Spalten URL (Crawl), InLinks (Crawl) und Seitenzugriffe (Analytics) zu erhalten. Dazu werden alle überflüssigen Spalten der Crawl-Datei gelöscht und eine Spalte „Seitenzugriffe“ angehangen. Dort fügt ihr mittels der Funktion SVERWEIS die zugehörigen Daten der Spalte „Seitenaufrufe“ aus dem Analytics-Export ein.

Achtung: Google Analytics liefert die URLs ohne „http://domain.de“ aus. Um den SVERWEIS durchzuführen müsst ihr diesen Teil an alle URLs anfügen (z.B. mit Funktion VERKETTEN), sonst erhaltet Ihr Fehler.

Bewertung der Verlinkung

Da es hier um eine große Anzahl an URLs geht, muss man nun Kennzahlen finden, anhand derer man bewerten kann, wie gut oder schlecht eine URL verlinkt ist. Ich möchte die folgenden Kennzahlen verwenden:

Anteil der Links, welche die einzelne Unterseite bekommt. Berechnung: Anzahl interner Links der einzelnen URL geteilt durch Gesamtanzahl der internen Links (Summe der Spalte „InLinks“). Damit erhält man eine Einschätzung der Priorität einer URL innerhalb der Seite anhand der internen Verlinkung.

Anteil Traffic, den die einzelne Unterseite bekommt. Berechnung: Anzahl der Seitenzugriffe der einzelnen URL, geteilt durch den Gesamttraffic aller URLs (Summe der Spalte „Seitenzugriffe“). Damit erhält man eine Priorisierung der URLs nach Traffic.

Potenzial. Berechnung: Anteil Traffic, den die einzelne Unterseite bekommt geteilt durch Anteil der Links, welche die einzelne Unterseite bekommt.

Hohes Potenzial bedeutet in diesem Modell, dass die Unterseite bereits guten Traffic hat, aber verhältnismäßig schlecht verlinkt ist. Ordnet man nun die URLs absteigend nach Potenzial, findet man im oberen Teil der Tabelle jene Unterseiten, welche wohlmöglich durch eine zusätzliche Verlinkung noch weiteren Traffic generieren können, da sie ihre Relevanz bereits bewiesen haben.

Einschätzung des Potenzials

Nun ist es wichtig, den Kopf anzuschalten. 😉 Es liegt nun das Ergebnis einer ziemlich einfachen Analyse vor, welches Fehleranfällig ist und zahlreiche Parameter nicht einbeziehen kann.

Dennoch kann man z.B. folgende Regelung treffen:

- Potenzial > 100 ==> Hier lässt sich die Verlinkung ziemlich sicher noch optimieren

- 100 > Potenzial > 50 ==> Hier sollte man auf jeden Fall genauer hinschauen

- 50 > Potenzial > 10 ==> Hier lässt sich wahrscheinlich nicht mehr viel machen, dennoch kann man die URLs mal überfliegen

- 10 > Potenzial ==> Diese Seiten sind schon entsprechend verlinkt oder gar zu stark verlinkt

Natürlich muss man für jede URL hinterfragen, ob das berechnete Potenzial das tatsächliche Potenzial wiederspiegelt. Dennoch ist die Ordnung der URLs nach der Kennzahl eine gute Erst-Sortierung.

Umkehrung des Modells – Verschenkte Linkpower

Natürlich kann man die Liste auch aufsteigend anordnen oder von unten an betrachten. Man findet dann als erstes jene URLs, welche unverhältnismäßig stark verlinkt sind. Hier kann man z.B. ableiten, dass ein bestimmter Link auf der Seite entfernt werden sollte.

Achtung: Kopf an! Das Impressum hat vermutlich einen schlechten Potenzial-Wert. Dennoch sollte man den Footer-Link nicht entfernen. 😉

Einschränkungen

Wie schon angemerkt, ist das Modell ziemlich einfach und kann deshalb nur eine grobe Einschätzung des Potenzials geben. Anhand der Priorisierung lässt sich aber schon eine Menge händische Arbeit sparen und man hat eine gute Auswahl der URLs für weitere Analysen.

Auch können natürlich beliebige weitere Kennzahlen einbezogen werden. Hier ist Kreativität gefragt. So könnte man z.B. die Anzahl der Klicks, die nötig sind, um die Seite zu erreichen mit einbeziehen oder sich nur auf organischen Traffic stützen.

Ich freue mich auf eure Ideen. 🙂

[…] Aufdecken von internem Link-Potenzial mit der Screaming Frog SEO Spider […]

Klasse Idee, setz ich gleich mal um. Statt screaming frog kann man wahrscheinlich auch die Webmaster Tools einsetzen.

1. keine Beschränkung auf 500 urls

2. Links auf noindex-Seiten werden bei den wmt ignoriert

3. wenn eine url von einer Seite mehrfach verlinkt ist, wird (glaube ich) nur ein Link gezählt (k.a. wie das bei screaming frog aussieht)

4. Javascript Links werden auch erkannt

lg

[…] Oftmals ist Website-Betreibern das Potenzial der eigenen Linkstruktur aber gar nicht bewusst. Der Projecter-Blog zeigt, wie man mithilfe von Screaming Frog SEO Spider und Daten aus Google Analytics eine gute […]

Vielen Dank für den tollen Tipp. Das werde ich gleich mal umsetzten. LG, der Ralf

[…] der internen Verlinkung häufig nicht erkannt. Dazu hat der Projecter-Blog in dieser Woche einen hilfreichen Artikel veröffentlicht, der zeigt, wie man diesem unausgeschöpften Potenzial mithilfe des Screaming Frog […]

Sehr schöner Artikel, gefällt mir sehr.

Ein ähnliches Thema hatte ich bereits mit einen meiner Mitarbeiter und habe den Artikel direkt mal an ihn weitergeleitet.

Beste Grüße

Mark

Hallo Stefan,

ich bin durch Zufall auf deinen Blog gestossen.

Ich befasse mich viel mit SEO, jedoch merke ich das es noch so vieles zu lernen und entdecken gibt.

Vielen Dank für den Artikel..

VG aus Köln

Frank